lingdata

Сайт курса «Лингвистические данные», бакалавры 1 курс НИУ ВШЭ

Конкордансеры. Практикум AntConc

AntConc – корпусный менеджер

- Страница программы, где её можно скачать и посмотреть инструкции

Знакомство с основными функциями

- Загрузите файл, проверьте, что он отображается нормально (вкладка FileView).

- Если нужно, настройте кодировку (меню Global Settings - Char Encoding).

- Чтобы слова с дефисами считались одним токеном, добавьте Connector и Dash в меню Global Settings - Token Definition.

- Постройте частотный список слов романа (вкладка Word List, нажмите кнопку Start). Кликнув на слово, вы сможете попасть в конкорданс, построенный для этого слова.

- В Word List отсортируйте частотный список по алфавиту (Sort by Word внизу страницы).

- Постройте частотный список двух-, трех- и т.д. -словных словосочетаний (вкладка Cluster/N-Grams, поставьте галочку на N-Grams, укажите, сколько слов в ngram-е вы хотите видеть, например, Min:3, Max:3, установите порог вхождений в корпусе, например, 10). Кликнув на n-грам, вы также можете попасть в его конкорданс.

- Постройте списки коллокатов выбранного вами слова (вкладка Collocates), указав границы окна справа / слева.

Работа с размеченными файлами

- Постройте частотный список, игнорируя теги xml (см. xml-файл с расширением xhtml. Чтобы его открыть, укажите Все типы файлов). В настройках Global Settings - Tag - Hide tags.

Работа с корпусами

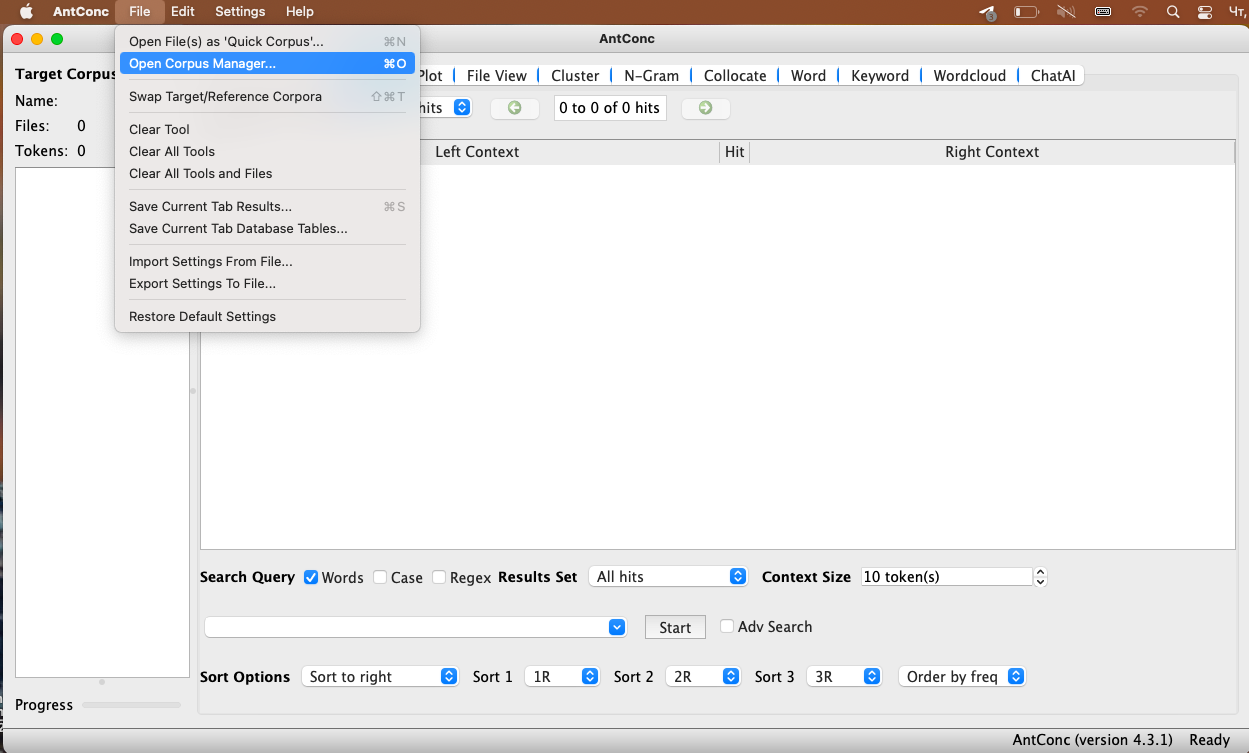

- Чтобы создать корпус из собственных файлов, откройте менеджер корпусов: (File > Open Сorpus Manager).

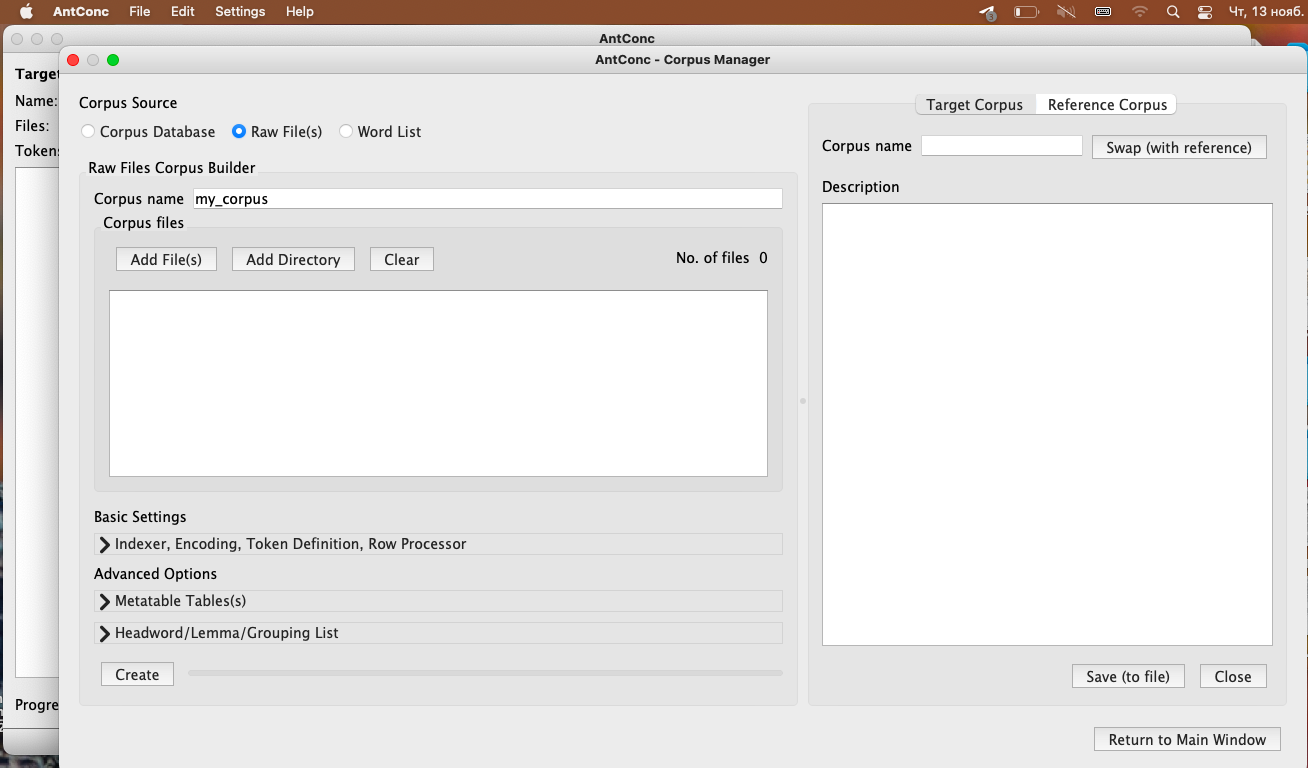

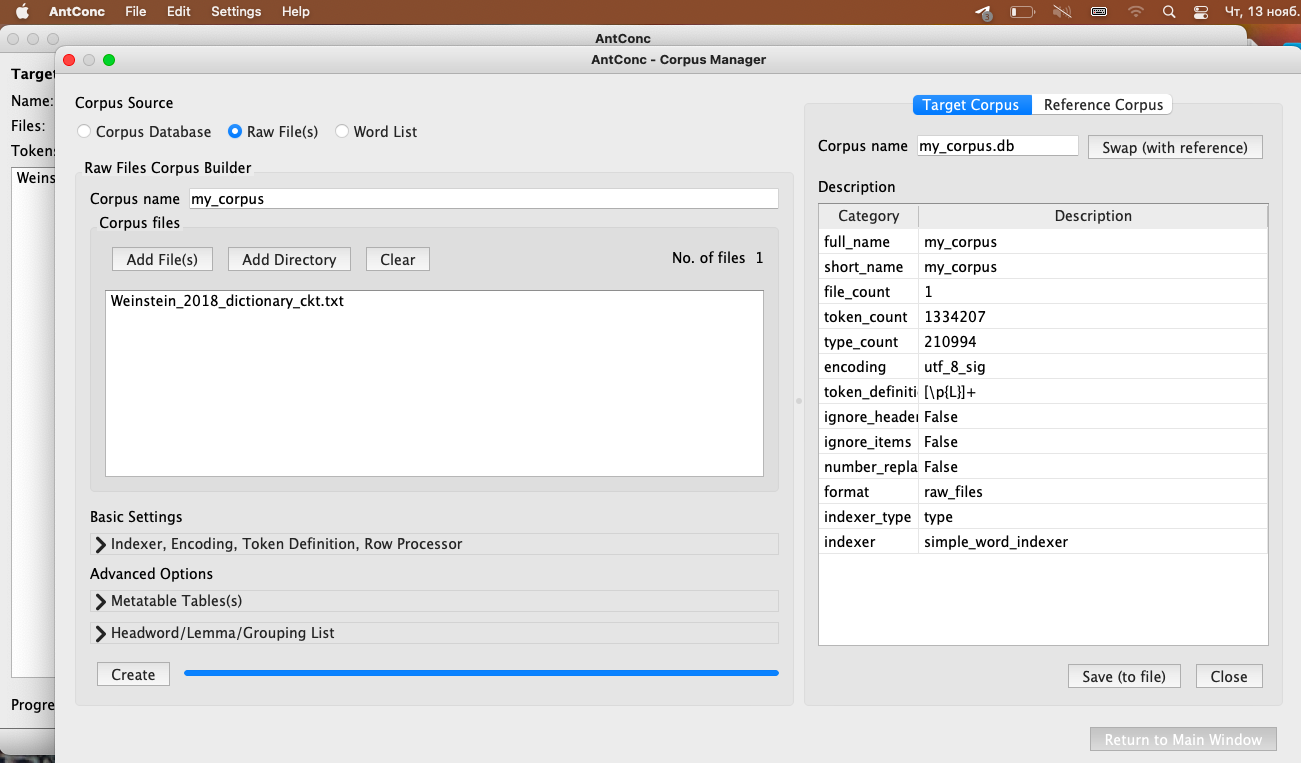

- Зайдите в Raw File(s) и добавьте отдельные файлы (Add File(s)) или целые папки (Add Directory). Нажмите Create.

- После создания справа появится табличка с данными о получившемся корпусе.

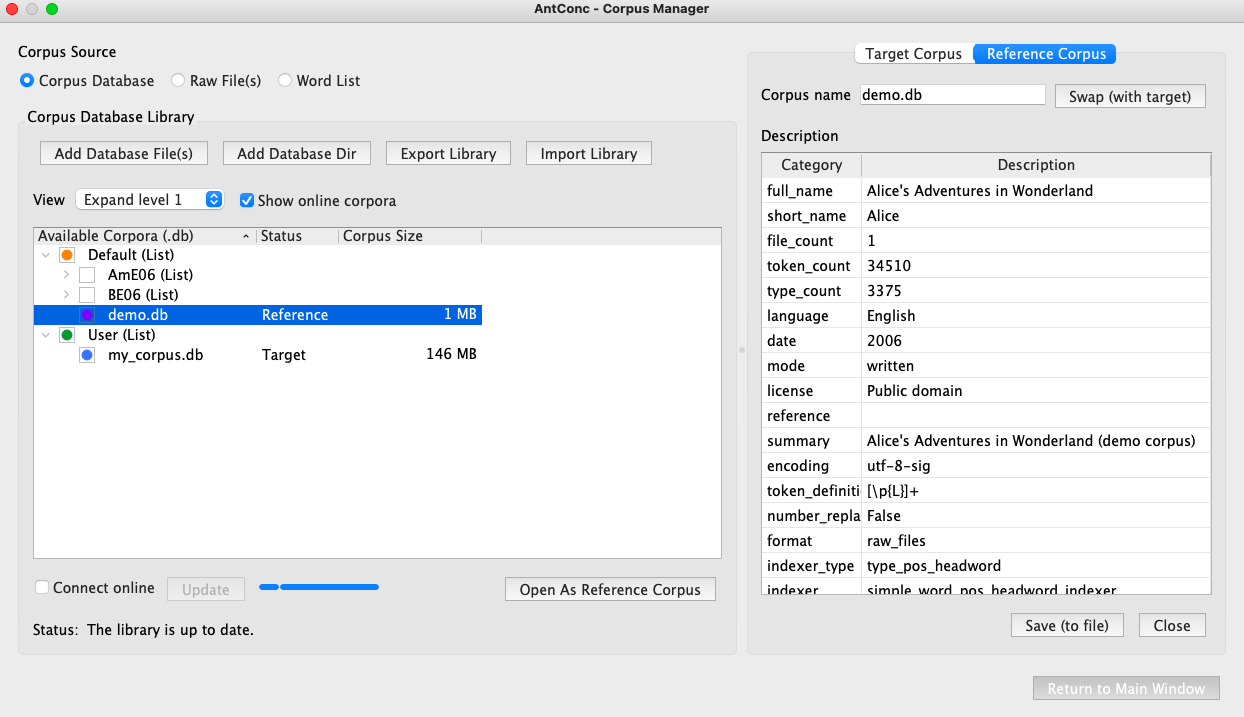

- Для добавления второго крпуса для сравнения (reference corpus), откройте менеджер корпусов: (File > Open Сorpus Manager), нажмите “Reference corpus” и выберите слева нужный вам корпус из доступных.

Ключевые слова (лексические маркеры - токены)

Чтобы определить характерные для некоторого корпуса слова, мы должны сравнить их частоты в данном корпусе с частотами в другом корпусе - reference corpus.

- Загрузите SynTagRus в качестве reference corpus:

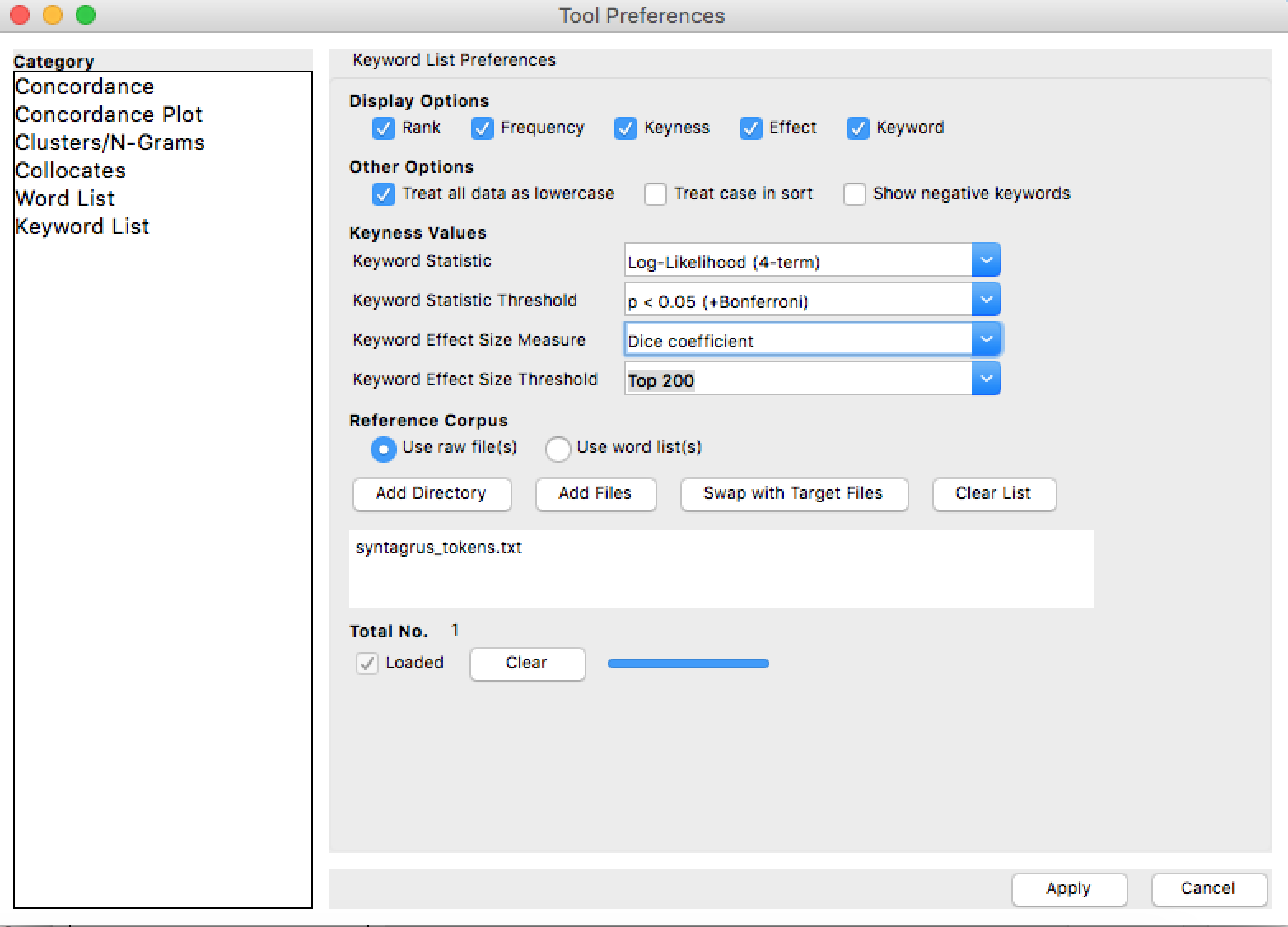

Settings > Tool Preferences > Keyword List

Use raw files – Add files

-

Там же в настройках установите Log-Likelyhood (4-term) в качестве статистической метрики определения keyness и Длину списка в 1000 слов (Keyword Effect Size Threshold). – Apply

-

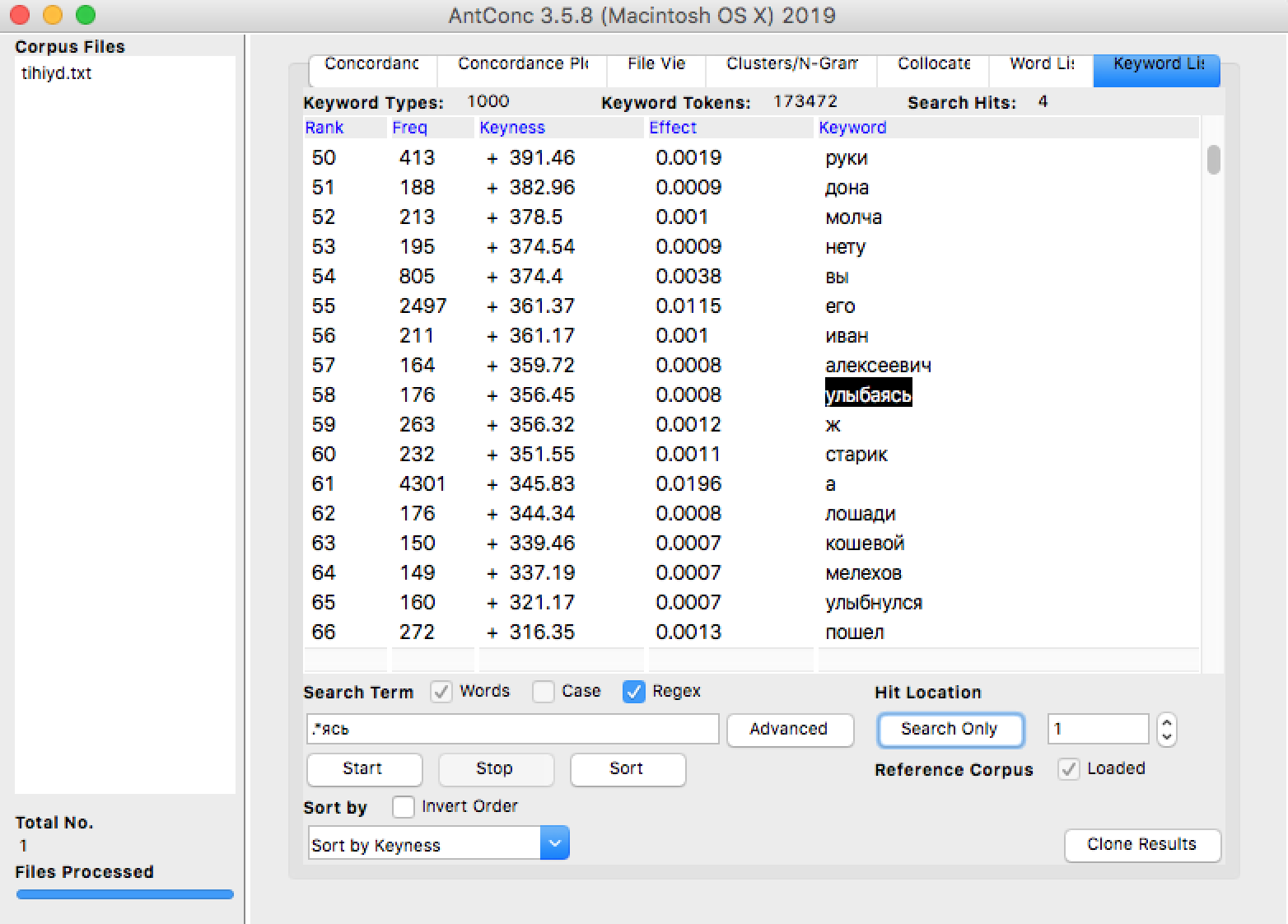

Перейдите на вкладку Keyword List > Start Для новых файлов AntConc начнет генерацию словника (выдаст предупреждение jump to Word List). В результате на вкладке Keyword List появится список ключевых слов, отсортированный по убыванию метрики Keyness (Log-Likelyhood).

- Чтобы найти интересующее слово в этом списке, введите его в поле Search Term и нажмите кнопку Search Only (не Start!). Кликнув на слово в списке, можно перейти к конкордансу.

Частотные списки лемм и списки ключевых слов (леммы)

Чтобы построить частотный список лемм, ваш корпус должен быть лемматизирован (reference corpus, естественно, тоже). Мы будем использовать версии корпусов с подстановкой вместо токена метки леммы и части речи (в формате lemma_POS).

Коллокаты

Во вкладке Collocates укажите слово, сочетаемость которого вы хотите изучить. Справа укажите контекстное окно поиска коллокатов (например, 0 слов слева, 2 слова справа - 2R) и частотный порог (Min. Collocate Frequency). Start!

Списки коллокатов можно сортировать по абсолютной частоте, метрике коллокационной связи (Stat) и алфавиту.

В Settings > Tool Preferences > Collocates можно выбрать метрики MI, Log-Likelihood, T-Score.

- T-Score - самая консервативная метрика, при ранжировании по ней уменьшается частотный ранг самых частотных слов корпуса и несколько увеличивается частотный ранг редких слов, но в целом ранги по абсолютной частоте и по T-Score похожи.

- MI (Mutual Information) - напротив, поднимает очень высоко в рейтинге слова, которые редко встречаются в корпусе в целом. Поэтому рекомендуют использовать эту метрику вместе с порогом отсечения очень редких слов.

- Log-Likelihood (LL-score, G2) - ближе к T-Score и больше понижает в рейтиге высокочастотные слова. Превосходит T-Score по соотношению точность/полнота, как показывает ряд исследований для английского языка.

В целом, идеальной метрики для поиска коллокатов не существует. Для разных языков, корпусов разного размера и жанра, типа коллокаций та или иная метрика может быть лучше или хуже.

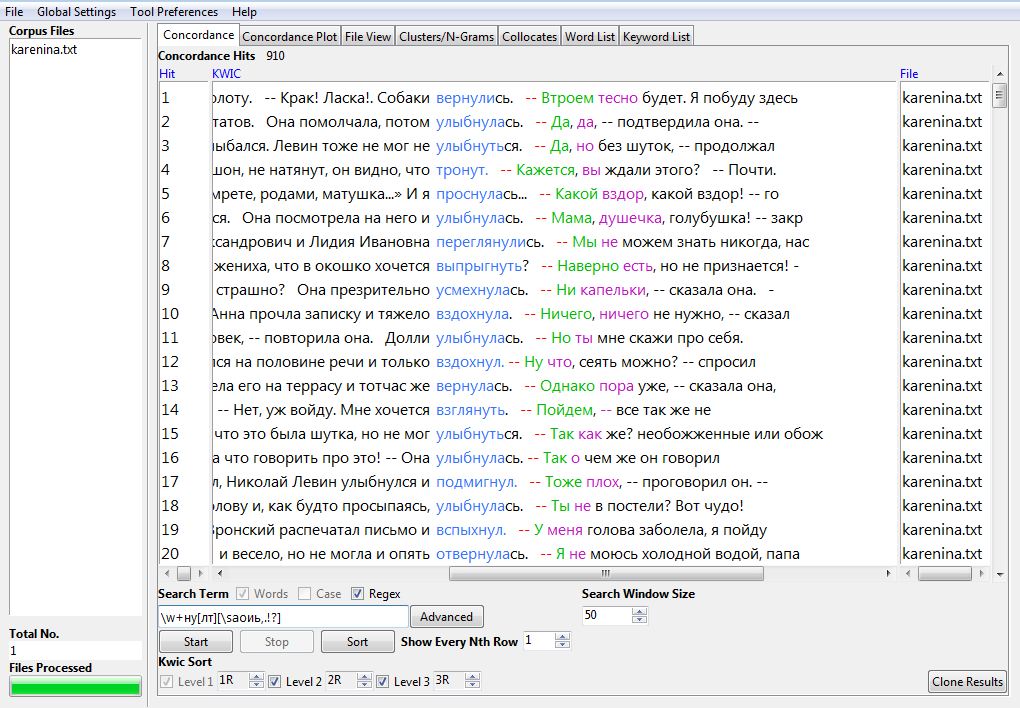

Поиск с использованием регулярных выражений

- Конкордансы и частотные списки можно строить с использованием Regex в Search Term. Например,

\w+нунайдет любое слово, содержащее -ну, но не частицу ну. Вот так я предполагаю найти все глаголы на -ну-.

э+ (второй символ - плюсик, третий - пробел) позволит найти э, ээ, эээ (AntConc по умолчанию считает пробел маркером конца слова).

Материал для работы на семинаре

Анна Каренина: plain text, xml, lemma_POS

Война и Мир, т. 1: plain text

Тихий Дон: plain text

LiveCorpus 2021:

tokens: см. файлы livecorpus2021-text-1.txt … livecorpus2021-text-10.txt в архиве по ссылке выше. lemma_POS: см. livecorpus2021_lemma_pos.1.txt там же.

Полезное

- Руководство по AntConc (на английском)

- Видео-тьюториал от автора

- Формулы и оценка коллокационных мер

Дополнительные материалы

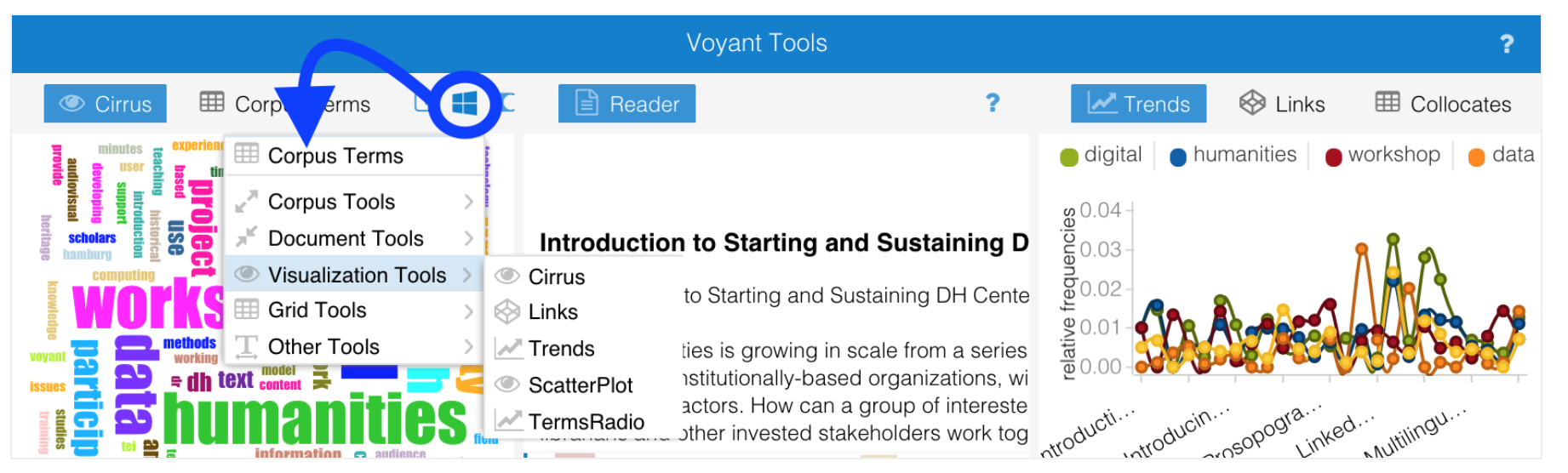

Voyant Tools

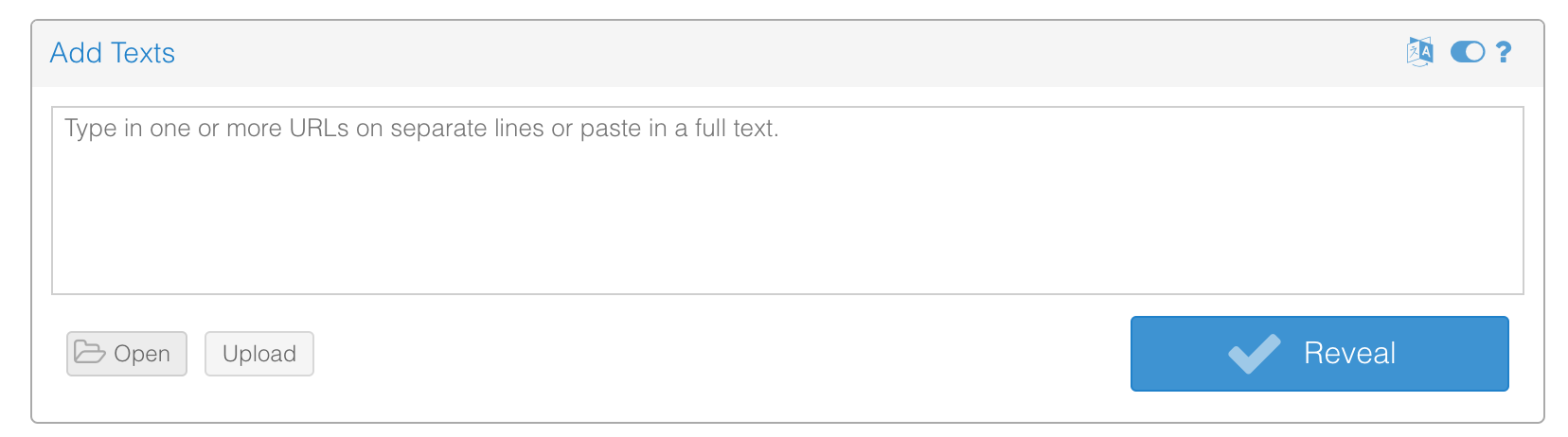

Еще одно полезное онлайн-приложение, которое используется гуманитариями - Voyant Tools.

- Изучить основные возможности инструмента можно на примере романов Дж. Остин > Open > Choose a corpus > Austen’s Novels

- Voyant Tools умеет строить облака слов (для всего корпуса и отдельных документов)

- показывает распределение частоты слов в документах

- показывает свойства документов, такие как длина в словах, среднее количество слов в предложении и т. д. пример

- вернувшись на исходную страницу, вы можете загрузить и исследовать свой пользовательский корпус

- Справка по Voyant Tools